自然言語処理と人工知能の分野は、ここ数年で大きな成長を遂げています。OpenAI のさまざまな世代の Generative Pre-trained Transformer (GPT) モデルは、この分野のトップ プレーヤーの 1 つです。

これらのモデルは、次のような優れた能力で知られています。職場での使用言語生成と理解は、GPT-3.5 から GPT-4、さらに最近では GPT-4o にかけて大幅に向上しました。

各モデルは以前のモデルよりも優れており、特別な品質、パフォーマンスの向上、および可能な用途を備えた新しい特徴と機能を実現しています。

これらの違いを理解することで、業界全体にわたる実用的なアプリケーションや研究開発など、目的に合わせて AI テクノロジーを最大限に活用できるようになります。

| 特徴 | GPT-3.5 | GPT-4 | GPT-4o |

| 発売日 | 2022年11月 | 2023年3月 | 2024年6月 |

| コンテキストウィンドウ | 最大4,096トークン | 最大8,192トークン | 最大32,768トークン |

| APIについて | OpenAI経由で利用可能 | OpenAI経由で利用可能 | OpenAI経由で利用可能 |

| バリエーション | 標準と微調整 | 標準と微調整 | 最適化され、微調整された、高性能 |

| トークン | 1750億のパラメータ | 2,800億のパラメータ | 3200億のパラメータ |

| 価格 | 無料 | 月額20ドル | 回数制限付き無料利用 |

GPT-4o (Omni) : 最もアップグレードされたモデル

OpenAI は、多言語、マルチモーダル生成型事前トレーニング済みトランスフォーマー GPT-4o を開発しました。2024 年 5 月 13 日、ライブ ストリーミングされたデモ中に、OpenAI の CTO Mira Murati が発表し、同日、利用可能になりました。

GPT-4o は無料ですが、ChatGPT Plus のお客様には 5 倍の使用制限があります。英語のテキストとコードでは GPT-4 Turbo のパフォーマンスに匹敵し、英語以外の言語のテキストでは大幅に上回ります。

また、API では 50% 安価で、はるかに高速です。聴覚と視覚の理解の点では、GPT-4o は以前のモデルよりも優れたパフォーマンスを発揮します。

128k のコンテキスト ウィンドウのおかげで、GPT-4o は人間の話し声と同じように、音に即座に反応できます。平均 232 ミリ秒、最大 320 ミリ秒で音に反応します。これは、会話中に人間が質問に通常応答する速度に似ています。

モーダル機能

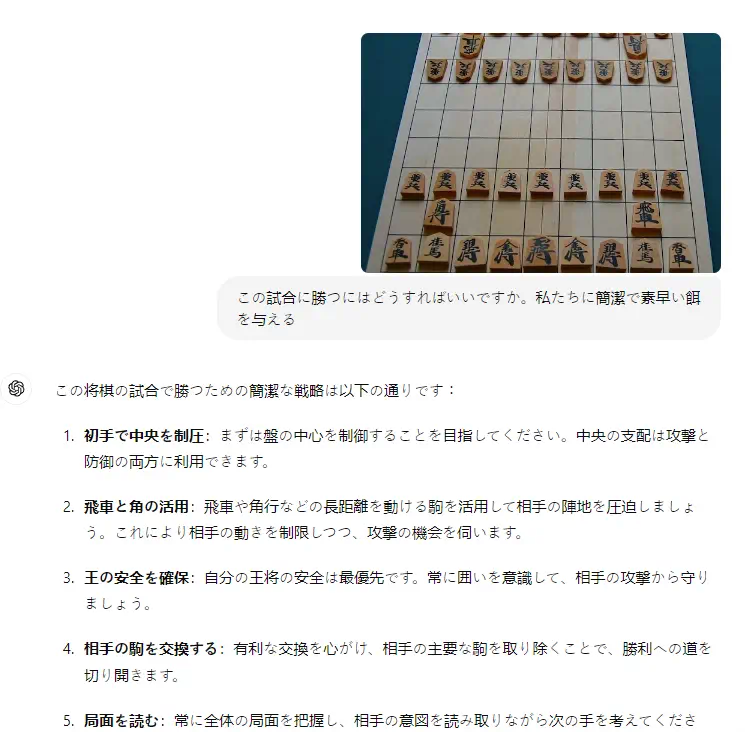

GPT-4o のマルチモーダル機能により、よりダイナミックで魅力的なメディア作成が可能になります。

GPT-4o は、テキスト、画像、ビデオをシームレスに統合し、創造性、教育、顧客サービス、ヘルスケア、エンターテイメントの新たな可能性を切り開きます。

リアルタイムのビデオチャット

GPT-4o は、迅速に応答し、さまざまな声で話し、感情を表現することができる人工知能と会話できるため、利用可能なすべての ChatGPT モデルよりも優れています。実際のチャットと同じように、ChatGPT セッションを途中で終了することもできます。

さまざまな状況に合わせて声のトーンを調節できるため、やりとりがより個人的で魅力的になります。話題に応じて、真剣、同情的、または熱狂的に聞こえることもあります。

GPT-4o は、感情的に反応することで人々の理解度を高め、やりとりの現実感を高めることもできます。

このツールの迅速な応答能力により、より有機的で動的な会話の流れが可能になります。その結果、ユーザー入力と AI 応答の間のタイムラグが短縮されます。

多言語の専門知識

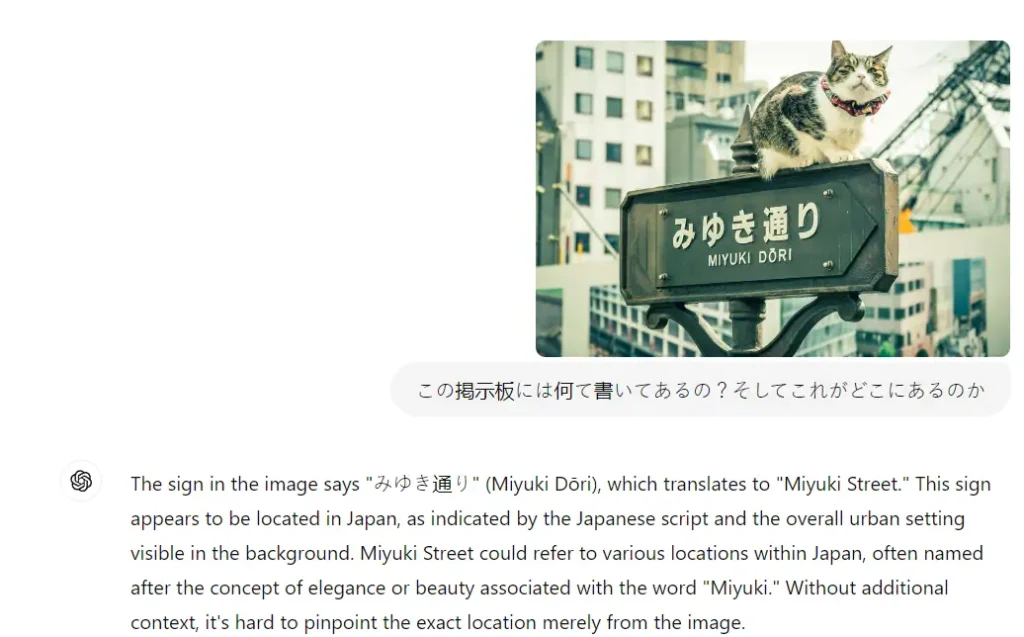

GPT-4o は、テキストのみに焦点を当てた GPT-4 とは対照的に、テキスト、視覚、聴覚の入力を処理して出力を生成する能力を組み合わせています。

新しいトークナイザーの圧縮がさまざまな言語ファミリーにわたってどのように表現されるかを示すために、20 の言語が選択されました。

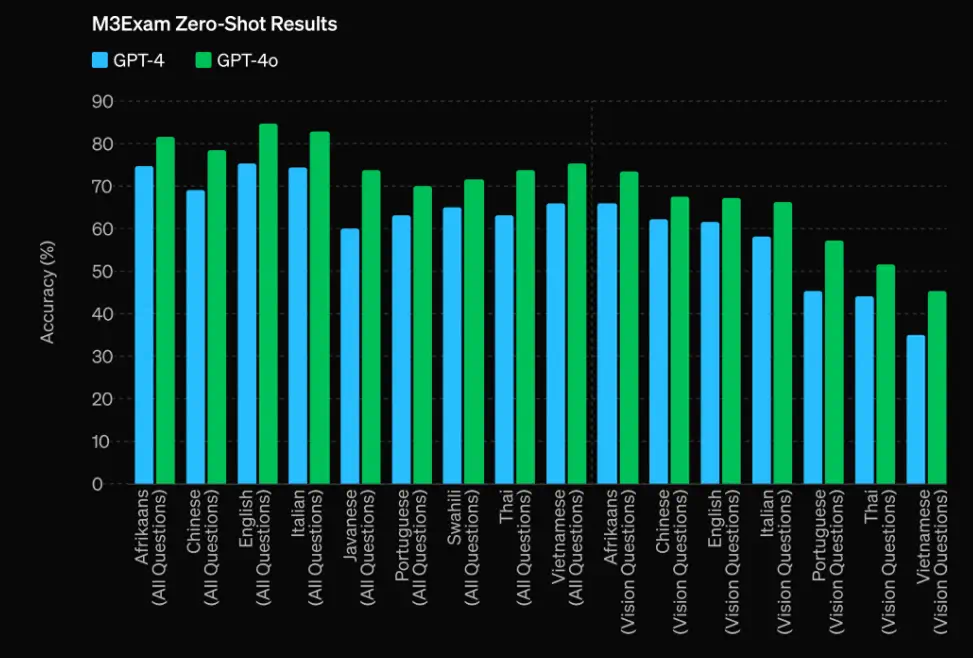

M3Exam と呼ばれる言語および視覚の評価は、さまざまな国の標準テストから派生した多肢選択式の質問で構成され、補助的なイラストや図が含まれる場合もありますが、GPT-4o は GPT-4 よりも優れたパフォーマンスを発揮します。

どの言語でも、GPT-4o は GPT-4 よりもこのテストで優れたパフォーマンスを発揮します。(スワヒリ語とジャワ語では視力に関する質問が 5 つ以下であるため、これらの言語の視力の結果は含まれていません。)

シーンでキャラクターを作る

GPT-4o は、一貫性のあるキャラクターを生成し、さまざまなタスクを実行するように依頼することができます。多くのユーザー、特にトレーニング プログラムに参加しているユーザーは、この機能を期待しています。

さまざまなシナリオや行動を通じて、同じ特徴を持つ 1 人のキャラクターを描写することになります。これには、指示書に記載されているさまざまな行動や状況を通じて、肌の色、髪型、アクセサリー、外見を一貫して維持することが含まれます。

音色と感情を理解する

GPT-4o は分析を通じて、テキスト、音声、またはビデオ キューのトーンと感情的なニュアンスを把握できます。会話がどれほどユーモラス、深刻、皮肉、または対立的であるかに関係なく、これらの詳細を検出して応答できます。

この機能により、やり取りがより人間らしく共感的なものになるだけでなく、顧客サービス、コンテンツ生成、メンタルヘルス、その他の分野での GPT-4o の潜在的な応用範囲も広がります。

GPT-4o は GPT-4 より優れていますか?

はい、GPT-4o は多くの点で GPT-4 よりも優れており、GPT-4 に比べて多くの利点があります。

マルチモーダルスキル

- テキスト生成、テキスト読み上げ、音声テキスト変換を統合モデルに組み合わせます。

- オーディオ入力を直接処理し、トーンや周囲のノイズなどの微妙な変化を拾います。

- 周囲の騒音や感情的な状況を考慮することで、回答の精度が向上します。

速度の向上

- 特により困難なタスクの場合、GPT-4 よりも処理速度が大幅に速くなります。

- 反応時間が短くなると、より自然なインタラクション感覚が促進され、ユーザー エクスペリエンスが向上します。

- 動的コンテンツ作成、ライブ翻訳、インタラクティブ AI などのリアルタイム アプリケーションに最適です。

コスト効率

- GPT-4 よりも 50% 安いコストで運用できるため、起業家や開発者の参入障壁が低くなります。

- コストが低いため、小規模な組織でも最先端の AI テクノロジーを活用できます。

- さらなる革新と受容を促進し、新たな AI アプリケーションと発見をもたらします。

GPT-4: 高度な ChatGPT モデル

Generative Pre-trained Transformer 4 は、OpenAI によって作成されたマルチモーダル大規模言語モデルであり、GPT 基礎モデル シリーズの 4 番目です。

2023年3月14日に、Microsoft Copilotの無料チャットボット、OpenAIのAPI、プレミアムチャットボットChatGPT Plusを通じて一般公開されました。

OpenAI のプレミアム バージョンである ChatGPT Plus は、リリース以来、使用率が大幅に増加しています。ChatGPT Plus は月額 20 ドルで利用でき、ユーザー エクスペリエンスとプログラムの機能性の両方を向上させる多くの機能と特典が含まれています。

GPT-4 は何ができるのでしょうか?

GPT-4 に追加された強化された画像プロンプト機能により、ユーザーはテキストと一緒に写真を入力して応答を生成できるようになりました。

この機能は、モデルの理解と視覚入力との相互作用を改善することで、デザイン、教育、エンターテイメントのアプリケーション、さらにはキーワード調査.

ユーザーは、GPT-4 に画像の説明や、画像に基づいたストーリーの展開を依頼したり、さらには画像のタグ付けや視覚分析などのタスクを実行したりすることもできます。GPT-4 は、マルチモーダル アプローチにより、視覚情報が重要なさまざまな状況でより適応性が高く、役立ちます。

ビジュアルコンテンツとのインタラクティブ性

GPT-4 のユーザーは、視覚コンテンツとの対話を可能にする機能により、画像を動的かつインタラクティブに操作できます。

ユーザーは写真を変更したり、写真内の特定のコンポーネントについて問い合わせたり、変更や改善をリクエストしたりできます。

詳細な視覚分析を実行し、創造的な取り組みについて意見を提供し、さらには視覚的なタスクでリアルタイムに協力する機能により、この機能はユーザーが AI と対話する方法を完全に変えます。

テキストデータと視覚データのシームレスな統合が可能になり、より包括的で魅力的なユーザー エクスペリエンスが実現します。

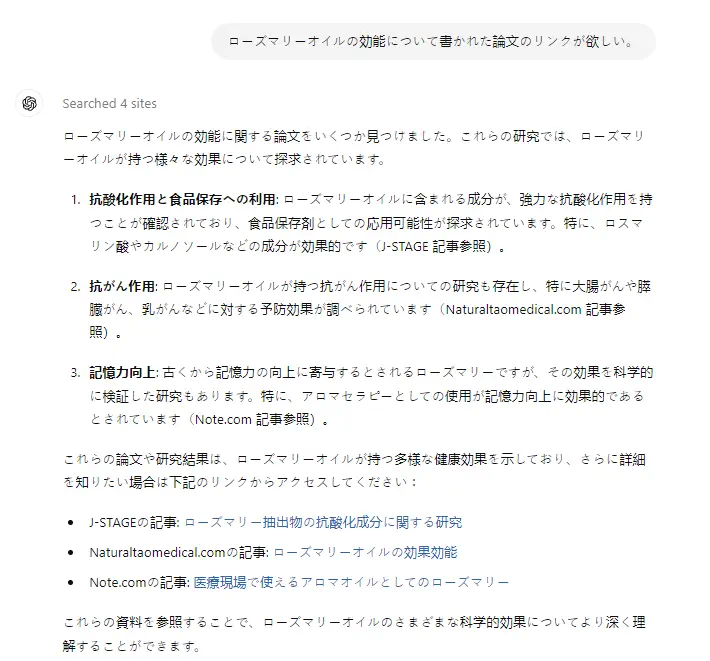

Bingでブラウジング

リアルタイムの Web 情報は、閲覧用に GPT-4 と Bing の接続を介してモデルによってアクセスおよび取得される場合があります。

この機能により、最新のデータを取得して最新の応答を提供できるようになり、GPT-4 の精度と関連性が向上します。

モデルには、特定の情報を検索したり、情報を確認したり、現在の出来事や傾向を調べたりするように要求できます。

ブラウジング機能により、GPT-4 は必要に応じてインターネットから新しいコンテンツを取得できるため、学習、研究、知識の維持に常に効果的なツールとなります。

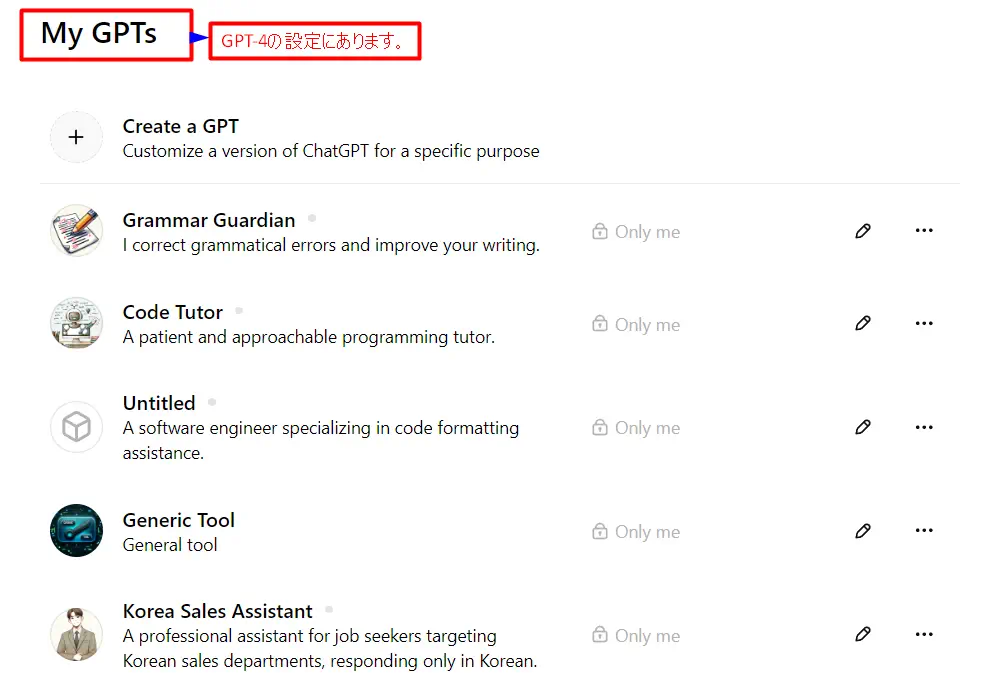

GPT-4 での GPT へのアクセス

GPT-4 の「GPT へのアクセス」という用語は、「カスタム GPT」と呼ばれる、GPT-4 モデルのいくつかのカスタマイズされたバージョンを操作して利用する機能を表します。

これらの特殊モデルは、特定のタスクやドメインに合わせて作られているため、特定のアプリケーションに対して向上した精度とパフォーマンスを顧客に提供します。

テクニカルライティングからクリエイティブプロジェクト、カスタマーサービス、その他のドメイン固有の要件に至るまで、ユーザーが専門知識やスキルを必要とする場合は、異なる GPT 間を移行できます。

GPT-4 はモジュール設計のため、さまざまなシナリオで非常に柔軟かつ効率的であり、ユーザーに手元の作業に最適なツールを提供します。

GPT-4 の改善とアップグレード

2 番目の高度な ChatGPT モデルは、GPT-3.5 に比べて多数の変更と機能強化を提供します。パフォーマンス、効率、高度な機能が主な機能強化です。

高度な機能

GPT-4 がより複雑かつ複雑な方法で自然言語を理解し、生成する能力は、その主な機能強化の 1 つになります。

GPT-3.5 よりもさらに難しい自然言語タスク、たとえばより技術的なテキストの読み取り、より創造的な資料の作成、低密度言語の翻訳などが可能になると期待されています。

GPT-4 は、法律文書や医学文書の解読など、特定の知識を必要とする自然言語処理も実行します。

このモデルは、GPT-3.5 よりもはるかに大きなデータセットからトレーニングできるため、自然言語の微妙なニュアンスや複雑さをより完全に把握できるようになると考えられています。

効率とパフォーマンス

さらに、GPT-4 は GPT-3.5 よりも機能性に優れ、より効果的であるはずです。GPT-3.5 と比較すると、このモデルはタスクをはるかに速く完了するため、チャットボットや仮想アシスタントなどのさまざまなリアルタイム アプリケーションでの使用に適しています。

さらに、GPT-4 は GPT-3.5 よりも大きなデータセットを処理できるはずであり、これにより、より多くのインスタンスから学習できるようになり、自然言語の複雑さと精巧さをより適切に捉えることができるようになります。

応答時間の短縮

主な機能強化の 1 つは、GPT-4 の処理能力の最適化であり、これにより反応時間が短縮されます。

この開発は、会話型 AI、ライブ顧客サポート、インタラクティブ アプリなどのリアルタイム コンタクト アプリケーションに非常に有益です。

応答時間が短くなると、音声に似た GPT-4 とのよりスムーズで自然なやり取りが可能になり、ユーザー エクスペリエンスが向上します。

GPT-3.5: GPT-3の改良版

2022 年 11 月にリリースされた GPT-3 の改良版である GPT-3.5 は現在、有料の Turbo API と無料の ChatGPT Web アプリを通じて利用できます。

GPT-3.5 は過去に何を提供していましたか?

OpenAI の GPT-3.5 シリーズは、GPT-3 などの前身に比べて改良されており、生成型事前トレーニング済みトランスフォーマー モデルの機能が大幅に進歩したことを示しています。

人間のようなテキスト

GPT-3.5 は、そのバリエーションである text-davinci-002 および text-davinci-003 とともに、人間の言語に近いテキストを生成することを目的としています。この改良により、モデルの出力は人間の文章にさらに近くなるはずです。

これらのモデルは、より洗練され、コンテキストに適した応答を生成し、無意味または無関係なコンテンツを生成する可能性が低くなります。

より優れたトレーニング アルゴリズムと微調整手順により、GPT-3.5 は自然言語の豊かさと繊細さをより正確に再現できるようになりました。

これは、高品質の書面によるコンテンツを必要とするチャットボット、コンテンツ生成ツール、顧客サービスの自動化などのアプリケーションに特に役立ちます。

多言語対応

GPT-3.5 は大きな進歩を遂げており、その 1 つは多言語機能の向上です。

以前のモデルでも一部の言語のテキストを理解して生成することはできましたが、GPT-3.5 はより広範囲の言語で優れたパフォーマンスを発揮します。

これは、言語や文化の癖を理解することが不可欠な国際的なアプリケーションにとって特に重要です。

多言語機能の向上により、モデルはテキストをより正確に翻訳し、コンテキストをより完全に理解し、さまざまな言語的背景を持つ人々とそれぞれの文化に適した方法でコミュニケーションできるようになります。

分析的推論

GPT-3.5 の強化された分析的推論スキルも注目すべき特徴です。

このモデルは、言語の生成と理解に優れているだけでなく、論理的推論を必要とする複雑なパズルを解くのにも優れています。

GPT-3.5 は、データの理解、分析に基づくソリューションの提供、さらにはコードの記述など、より高次の認知処理を必要とするジョブを処理するために作られています。

これにより、データ分析や学術研究など、意思決定のサポートが役立つあらゆる状況において貴重なツールとなります。

GPT-4o、GPT-4、GPT-3.5 の主な違い

長年にわたり、OpenAI GPT (Generative Pre-trained Transformer) シリーズは大きな進化を遂げ、各バージョンで自然言語処理の分野で大きな改善がもたらされました。

| 特徴 | GPT-3.5 | GPT-4 | GPT-4o |

| モデルアーキテクチャ | GPT-3 を強化、2021 年 6 月までのデータでトレーニング済み | 2022年までのより多様なデータでトレーニングされた、より大規模なモデル | さらに新しいデータを使用してアルゴリズムをさらに最適化 |

| パフォーマンス | 微妙なクエリ処理とコンテキストの維持の改善 | 回答の精度と文脈性の向上 | リアルタイム応答の効率と精度の向上 |

| 多言語対応 | GPT-3よりは優れているが、あまり一般的でない言語では一貫性がない | 英語以外の言語での大幅な改善 | さらに信頼性の高いサポートのための改良点 |

| 特別な機能 | 主にテキストと言語処理 | 機能は拡張されているが、言語に重点が置かれている | 高度な最適化により、より複雑なタスクをサポートできる可能性があります |

| インタラクティブ性 | 基本的なインタラクティブ機能、GPT-3よりも応答性が高い | より高度なコンテキスト認識によるインタラクティブ機能の強化 | 動的相互作用と適応性のさらなる改善 |

| API の強化 | 以前のモデルと同じ標準API機能 | 開発者向けのより強力なAPI機能の導入 | よりスムーズな統合を可能にする最適化されたAPI機能 |

| 研修費用 | かなり高いがGPT-4より低い | データセットとモデルのサイズが大きいため、トレーニングコストが高くなります。 | トレーニングプロセスの改良により、さらに高くなる可能性がある |

| 産業分野への応用 | 顧客サービス、コンテンツ作成に適しています | ヘルスケアや金融などのより複雑な分野を含む幅広い応用 | ライブデジタルアシスタントのような需要の高い環境向けに設計 |

| 曖昧さの扱い | 改善はされているが、複雑な状況では時々苦労する | 会話における曖昧な入力や微妙なニュアンスをより適切に処理 | 曖昧なユーザー入力を解釈して応答するのが得意 |

| プロンプトタイプ | テキストベースのプロンプトのみ。画像やビデオは処理しません。 | 分析と生成のための画像プロンプトをサポート | インタラクティブ性を高めるために画像とビデオの両方のプロンプトをサポート |

倫理的配慮

GPT-3.5、GPT-4、GPT-4o などの AI モデルには多くの利点がありますが、適切に処理する必要がある倫理的責任も伴います。

GPT-3.5 は以前のモデルよりも優れたパフォーマンスを発揮しましたが、偏見を強化する可能性のあるトレーニング データのバイアスが懸念の原因でした。

さらに、虚偽の情報を生み出す可能性があるため、特に虚偽の情報を流布する場合は、悪用を避けるための予防措置が必要です。

GPT-4 の拡張された機能は、これらの倫理的問題を拡大します。テキストを理解して生成する能力が強化されたため、出力に危険な情報が含まれていないことをより確実にすることに重点が置かれています。

さらに、GPT-4 の応答の正確性と適切性は、メンタルヘルスや法的ガイダンスなどの繊細な分野に応用される場合に非常に重要になり、人間による監視の必要性が浮き彫りになります。

GPT-4o のマルチモーダル機能 (テキスト、音声、視覚データを統合) は、これらの問題をさらに解決します。個人データが不適切に管理されると、この統合によってプライバシー侵害の可能性が生じます。

モデルのスピードと自律性が向上したため、その成果を倫理的かつ効果的に管理し、すべての人がその恩恵を受けられるようにし、社会的不平等を悪化させないようにするための厳格な管理も必要になります。

AI の機能が進歩するたびに、これらのテクノロジーの作成と応用を導く強力な倫理的枠組みがいかに重要であるかが強調されます。

結論

OpenAI の Generative Pre-trained Transformers の機能は、GPT-3.5 から GPT-4、そして最終的に GPT-4o へと大幅に進歩しました。

モデル アーキテクチャ、パフォーマンス、多言語機能、インタラクティブ性はすべて更新ごとに改善され、より多様な用途に対応するより高度なツールが提供されます。

GPT-4o のマルチモーダル機能と最適なパフォーマンスは特に重要であり、視覚データと音声データの統合に加えて、迅速かつ高度な言語処理を必要とする分野にとって非常に貴重なツールとなります。

よくある質問(FAQs)

GPT-4 と比較した GPT-4o の主な利点は何ですか?

GPT-4o は、マルチモーダル機能の向上、処理速度の向上、運用コストの削減を実現しているため、より複雑でインタラクティブなアプリケーションを処理できます。

GPT-4 は GPT-4o と同様に複数の言語を処理できますか?

GPT-4 の多言語機能は GPT-3.5 よりもはるかに優れていますが、GPT-4o は、特に英語以外のテキストの理解と生成に関しては、より幅広い言語でさらに信頼性の高いサポートを提供することで、さらに一歩進んでいます。

GPT モデルではデータのセキュリティとプライバシーはどのように処理されますか?

OpenAI では、強力なデータ処理とプライバシー プロトコルが実装されています。ただし、これらのモデルは、トレーニングに使用した大規模なデータセットで発見したパターンに基づいて結果を生成する可能性があるため、ユーザーは機密データを入力する際には注意する必要があります。

特定の業界の需要に合わせて GPT-4o を調整することは可能ですか?

はい、前身と同様に、GPT-4o では微調整が可能であり、企業はモデルを変更して特定のジョブに適合させ、ニッチなアプリケーションでのパフォーマンスを向上させることができます。

開発者はどのようにして GPT モデルをアプリに組み込むことができますか?

さまざまなソフトウェア アプリケーションでこれらのモデルを実装するための詳細なドキュメントとサポートを提供する OpenAI の API を通じて、開発者は GPT モデルを統合できます。